近幾年,生成式AI引領行業變革,AI訓練率先崛起,帶動高頻寬記憶體(High Bandwidth Memory, HBM)一飛沖天。但我們知道AI推理的廣泛應用才能推動AI普惠大眾。在AI推理方面,業內巨頭、初創公司等都看到了其前景並提前佈局。 AI推理也使得高頻寬記憶體HBM不再是唯一熱門,更多記憶體晶片與AI推理晶片結合,擁有了市場機會。已經有不少AI推理晶片、記憶體內運算(Computing in Memory, CIM)晶片將SRAM替代DRAM,從而獲得更快的存取速度、更低的刷新延遲等。

靜態隨機存取記憶體(Static Random-Access Memory, SRAM)是隨機存取記憶體的一種。這種記憶體只要保持通電,裡面儲存的數據就可以恒常保持。相對之下,動態隨機存取記憶體(DRAM)裡面所儲存的數據就需要週期性地更新。但當電力供應停止時,SRAM儲存的數據還是會消失,這與在斷電後還能儲存資料的ROM或閃存不同。

SRAM具有較高的效能,但SRAM的集成度較低,功耗較DRAM大,SRAM需要很大的面積。同樣面積的晶圓可以做出更大容量的DRAM,因此SRAM顯得更貴。SRAM可作為置於處理器(CPU)與主存間的快取記憶體,不需要定期刷新,響應速度非常快,可用於CPU的一級緩衝、二級緩衝。

Groq LPU近記憶體運算

在AI推理大潮下,Groq公司開發的語言處理器(Language Processing Unit, LPU),以其獨特的架構,帶來了極高的推理效能的表現。Groq的晶片採用14nm制程,搭載了230MB SRAM以保證記憶體頻寬,單晶片內建的記憶體(On-chip Memory)頻寬達80TB/s。

SRAM的存取速度比DRAM快得多,這使得它在某些運算密集型應用中表現得非常出色。Groq LPU晶片採用大容量SRAM記憶體有助於提高機器學習和AI等運算密集型工作負載的效率。

Groq成立於2016年,總部位於美國加利福尼亞州山景城,是一家AI推理晶片廠商。該公司核心團隊來源於Google最初的張量處理器(Tensor Processing Unit, TPU)工程團隊。Groq創始人兼CEO Jonathan Ross是Google TPU項目的核心研發人員。2024年8月,Groq在最新一輪融資中籌集了6.4億美元,由BlackRock Inc.基金領投,並得到了思科和三星投資部門的支持。2024年12月Groq在沙烏地阿拉伯達曼構建了中東地區最大的推理集群,該集群包括了19,000個Groq LPU,並在8天內上線。今年2月,Groq成功從沙烏地阿拉伯籌集15億美元融資,用於擴展其位於沙烏地阿拉伯的AI基礎設施。

Axelera AIPU晶片:記憶體計算+RISC-V架構

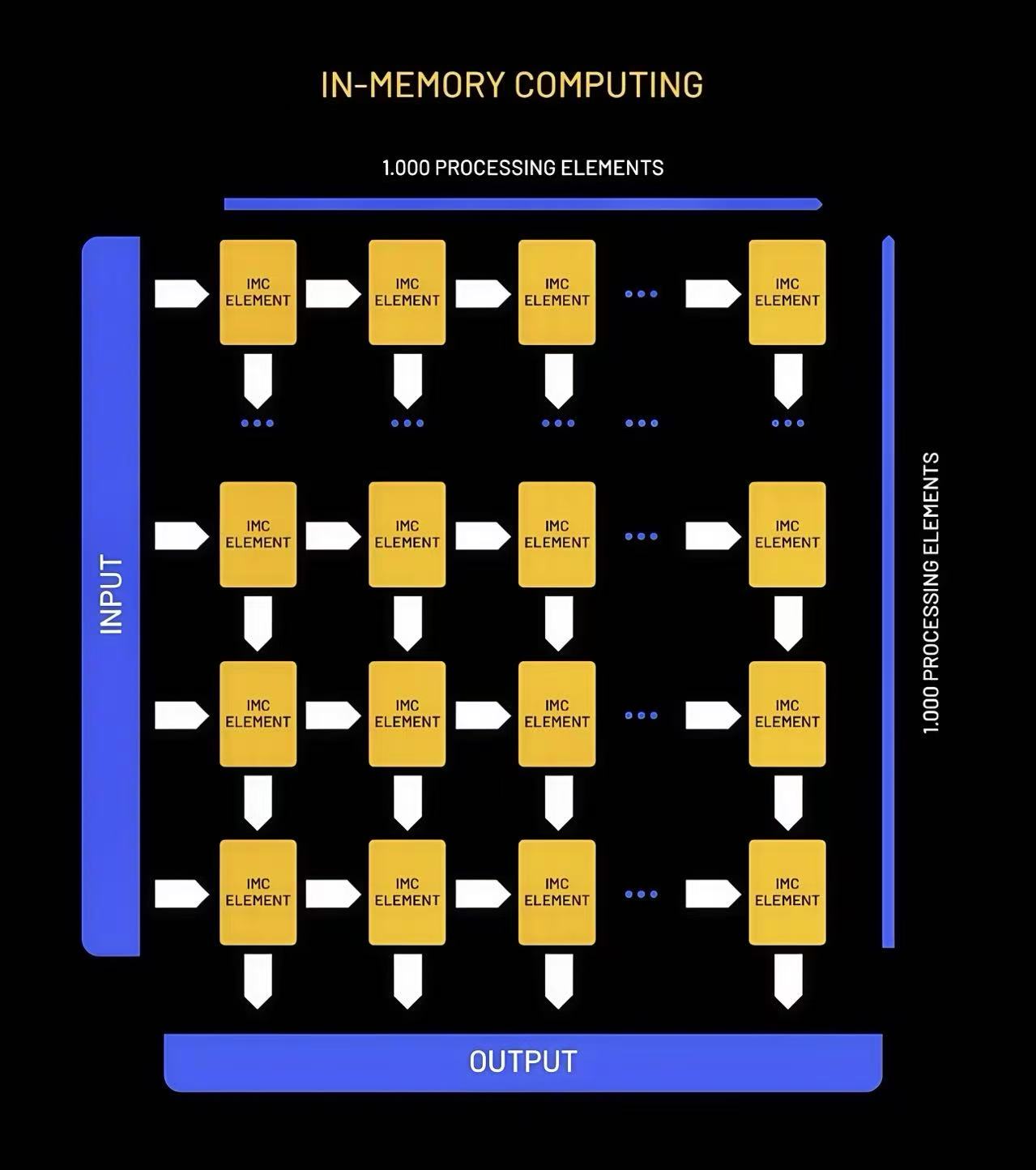

Axelera公司介紹,記憶體運算是一種完全不同的資料處理方法,在這種方法中,記憶體設備的橫桿陣列可以用來儲存矩陣,並在沒有中間數據移動的情况下“就地”執行矩陣向量乘法。專有的數位記憶體計算科技是實現高效能和卓越性能的關鍵。基於SRAM和數位計算相結合,每個儲存單元有效地成為一個運算單元。這從根本上新增了每個電腦週期的操作數(每個儲存單元每個週期一次乘法和一次累加),而不受譟音或較低精度等問題的影響。

Axelera的AIPU晶片採用了創新的記憶體運算技術。與傳統的磁碟片相比,記憶體運算將資料儲存在主記憶體(RAM)中,從而加快了資料處理速度。此技術使得Axelera的晶片在提供高效能運算的同時,能以更低的成本和功耗來進行邊緣AI運算。該晶片還採用了開源的RISC-V指令集架構(ISA)。RISC-V作為一種低成本、高效且靈活的ISA,允許根據特定的應用需求進行定制。它為Axelera提供了極大的設計自由度和創新空間。去年,Axelera獲得了來自三星電子風險投資部門三星Catalyst的大力支持,成功籌集了6,800萬美元,至此Axelera的總融資額已達到1.2億美元。新投資者包括三星基金、歐洲創新委員會基金、創新產業戰畧夥伴關係基金和Invest-NL。

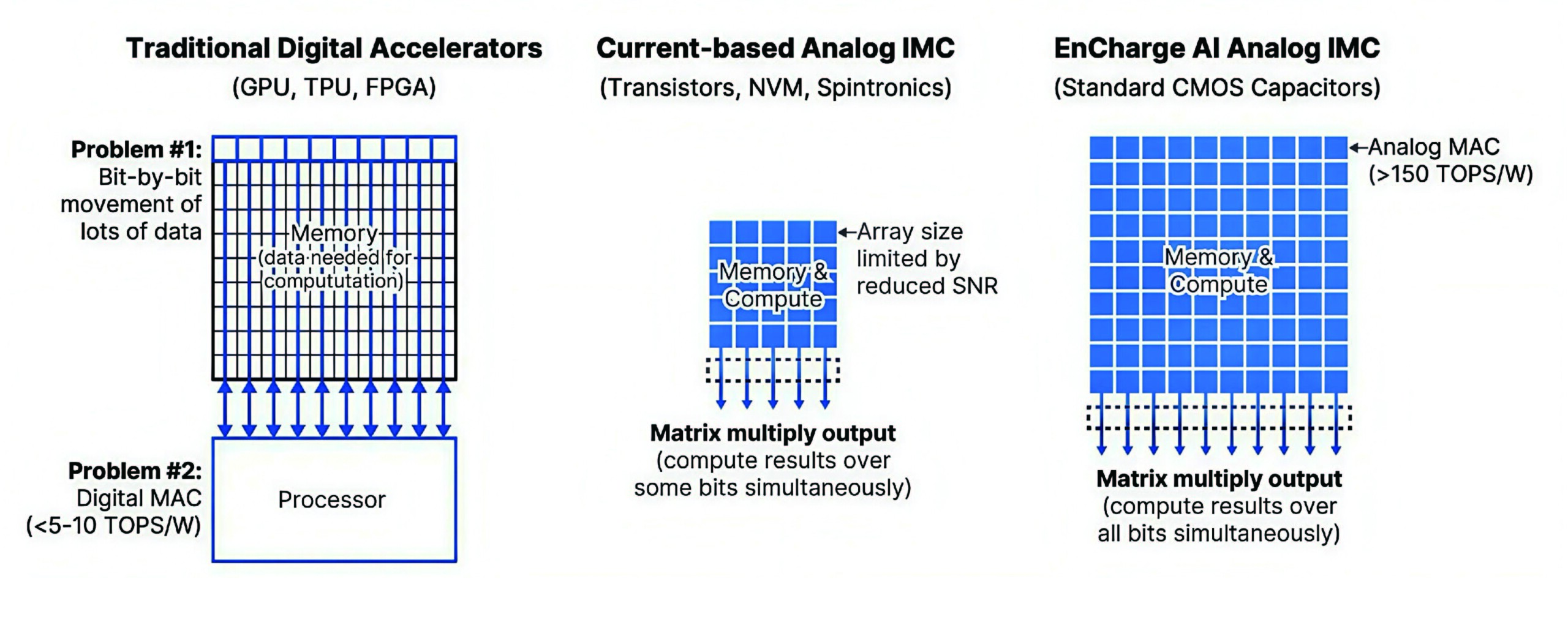

EnCharge AI:類比記憶體內運算

AI晶片初創公司EnCharge AI表示,已開發出一種用於AI推理的新型記憶體內運算架構,EnCharge AI的核心技術是基於類比記憶體運算的AI晶片。這種創新的晶片設計採用“基於電荷的記憶體”,通過讀取儲存平面上的電流而非單個位元(bit)來處理數據,使用更精確的電容器替代了傳統的電晶體。與GPU等數位加速器相比,每瓦效能提高了20倍。EnCharge AI的推理晶片僅需一瓦的功率就能以8位元精度提供150 TOPS的AI運算。EnCharge AI源自普林斯頓大學,該公司創始人兼CEO Naveen Verma的相關研究專案涉及到記憶體運算。用於機器學習運算的記憶體運算採用在RAM中運行計算的管道,以减少儲存設備帶來的延遲。

今年初,EnCharge AI完成超額認購的1億美元B輪融資。此輪超額認購融資使EnCharge AI的總融資額超過1.44億美元,將推動其首款以用戶端運算為主的AI加速器產品,並在2025年實現商業化。

D-Matrix:數位記憶體內運算DIMC架構

D-Matrix採用數位記憶體內運算(DIMC)的引擎架構將運算移動到RAM附近,該數位CIM技術將記憶體與運算單元中的乘積累加運算(Multiply Accumulate, MAC)進行了合併,獲得了更大的運算頻寬和效率,降低延遲,减少功耗。首批採用D-Matrix的DIMC架構的產品Jayhawk II處理器,包含約165億電晶體的Chiplet。每個Jayhawk II Chiplet都包含一個RISC-V核心對Chiplet進行管理,每個核心有八個並行操作的DIMC單元。去年底D-Matrix首款人工智慧晶片Corsair開始出貨。每張Corsair卡由多個DIMC運算核心驅動,具有2,400 TFLOP的8bit峰值運算能力、2GB SRAM和高達256GB的LPDDR6。

D-Matrix公司是一家位於Santa Clara的初創公司,專注於AI晶片的研發。該公司的主要產品是針對資料中心和雲端運算中的AI服務器設計的晶片,旨在優化AI推理工作負載。D-Matrix公司已經獲得了多家知名投資機構的支持,包括微軟風險投資部門、新加坡投資公司淡馬錫、Palo Alto Networks等,D-Matrix曾在2022年4月獲得了4,400萬美元融資,由M12和韓國電晶體製造商SK海力士公司領投。累計融資超過1.6億美元。

雖然說SRAM的擁有成本比較高,但其在AI推理運算中能够减少數據來回傳輸的延遲,避免拖慢整個AI處理的速度。在AI推理的浪潮下,SRAM將發揮更大的作用。

來源:本文由電子發燒友原創。